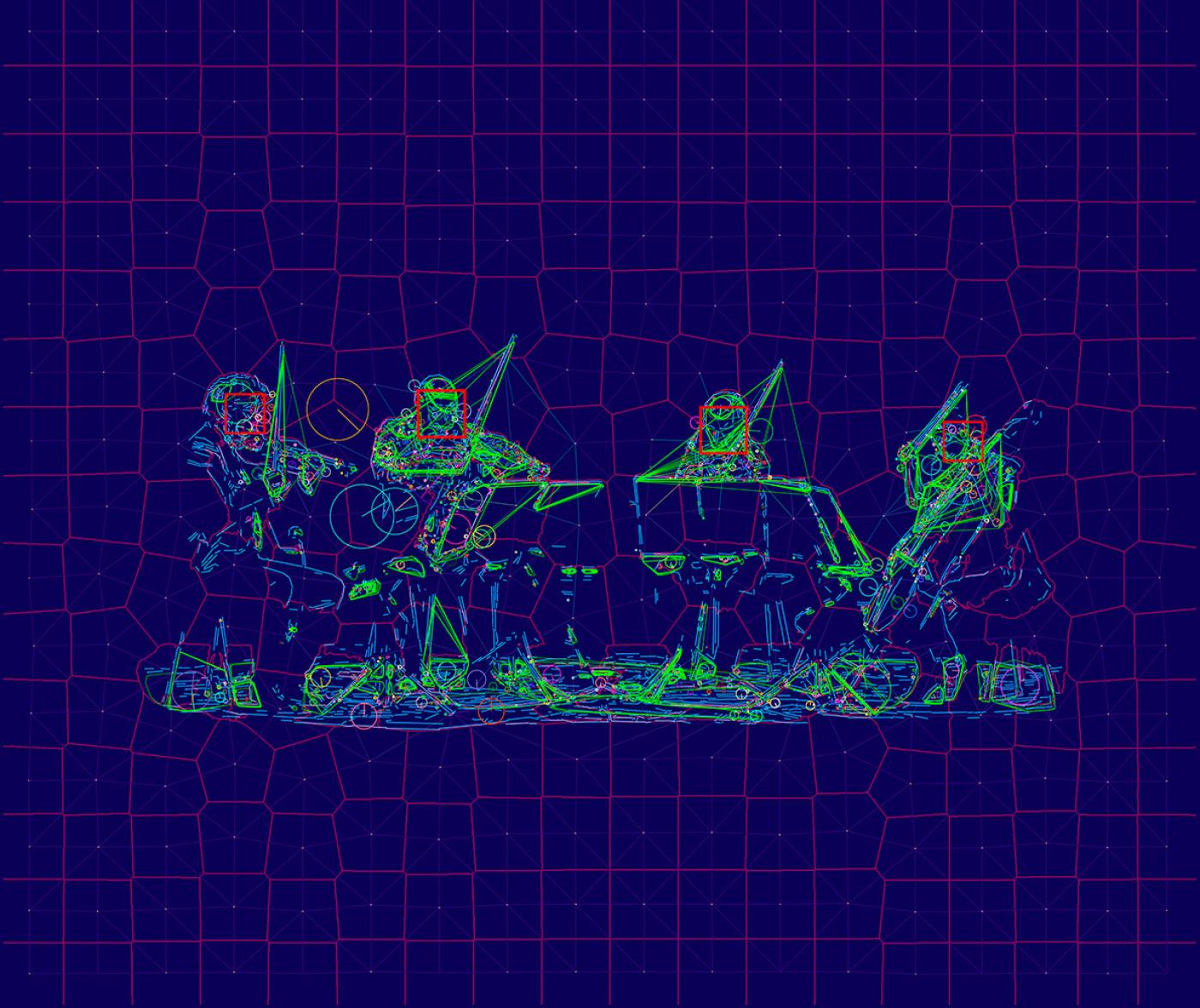

Regarder les nuages à travers les yeux d’une machine. Dans la photographie CLOUD #246 Hough Circle Transform (2019), l’artiste américain Trevor Paglen invite à voir une masse nuageuse comme le ferait un algorithme de reconnaissance de formes. Un maillage délicat de courbures et de lignes, resserré par endroits, vient se superposer à la prise de vue d’un cumulus s’élevant au ciel. La vision analytique de la machine et la texture même de son système de lecture sont ainsi rendues visibles. Cette pièce fait partie d’une longue recherche explorant le phénomène de machine vision, ou vision artificielle : la façon dont la vision par ordinateur, adossée à des systèmes algorithmiques et d’intelligence artificielle (IA), scrute notre monde.

L'œuvre, récemment acquise par le Frac Normandie, figure dans l’exposition collective « Images », à Sotteville-lès-Rouen (jusqu’au 3 septembre), dont les œuvres tentent de sonder « la nature de l’image à l’ère de sa reproduction numérique », précise Vincent Pécoil, commissaire de l'exposition et directeur du Frac. Parmi les questions abordées, présentes dans le travail de Trevor Paglen : le traitement automatisé des images et la surveillance. « La semaine même où on a ouvert cette exposition a justement été votée une loi autorisant la vidéosurveillance algorithmique lors des Jeux olympiques de Paris, s’inquiète le directeur. Dans une indifférence quasi générale. »

Impact sur la culture visuelle

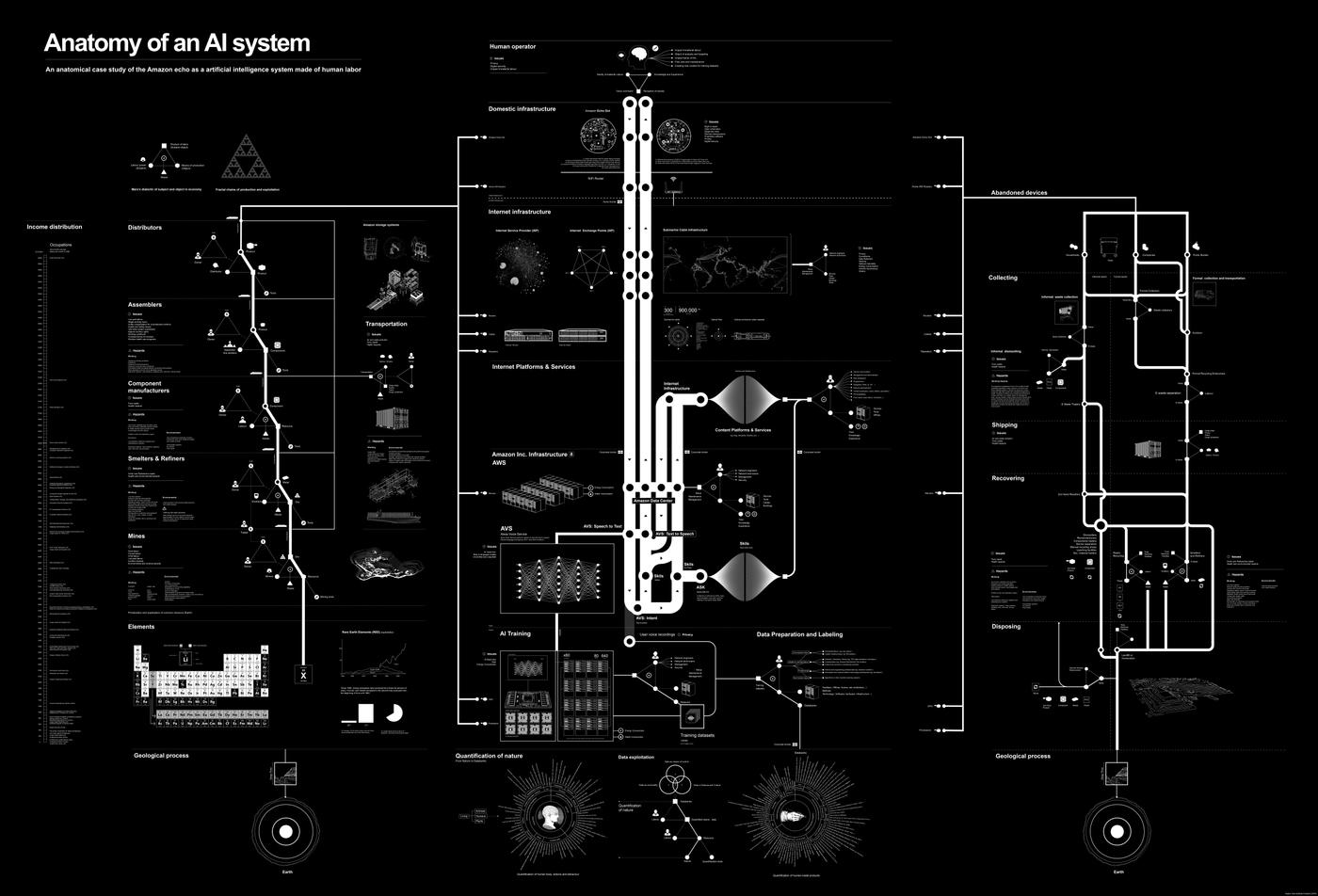

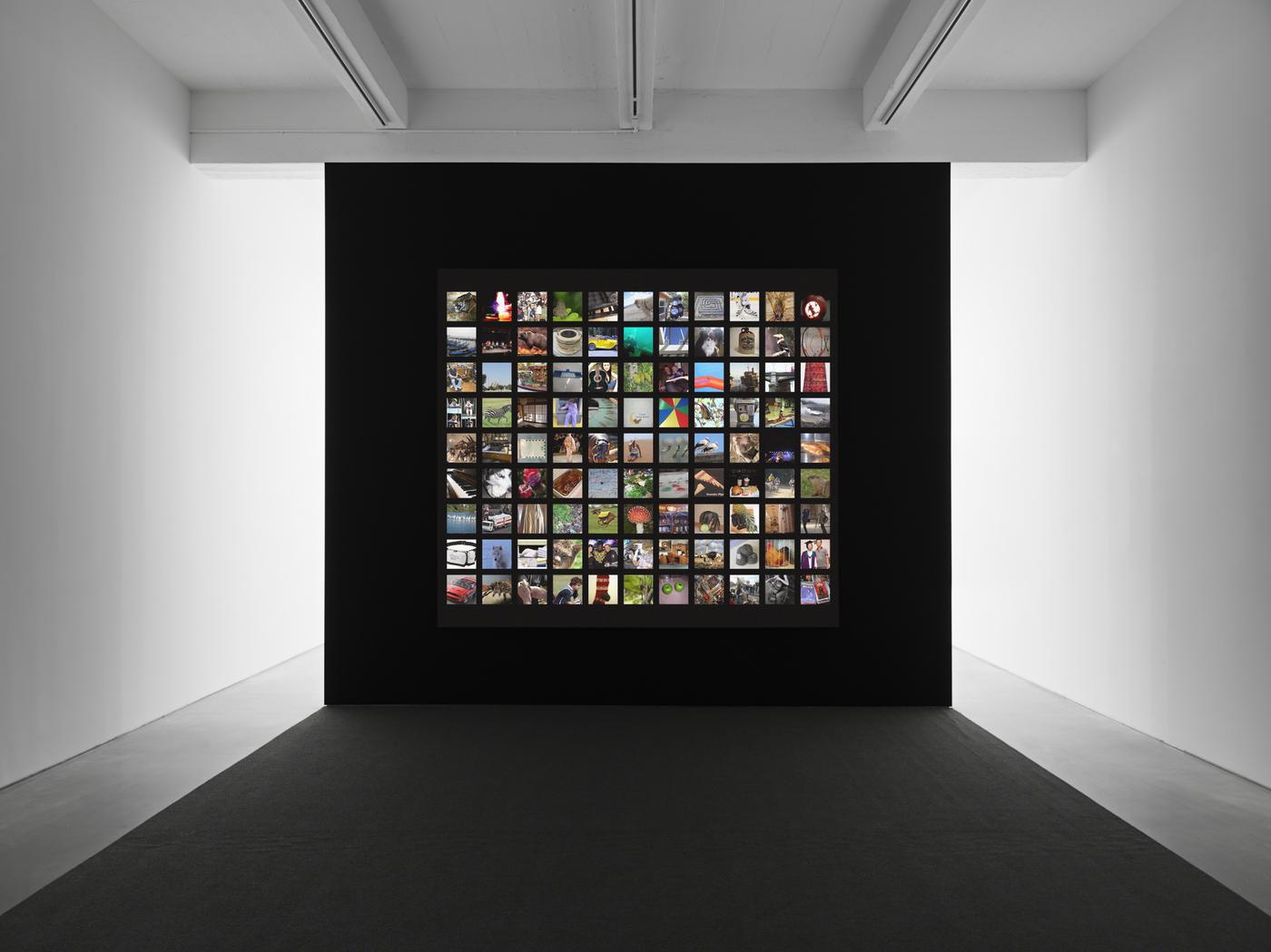

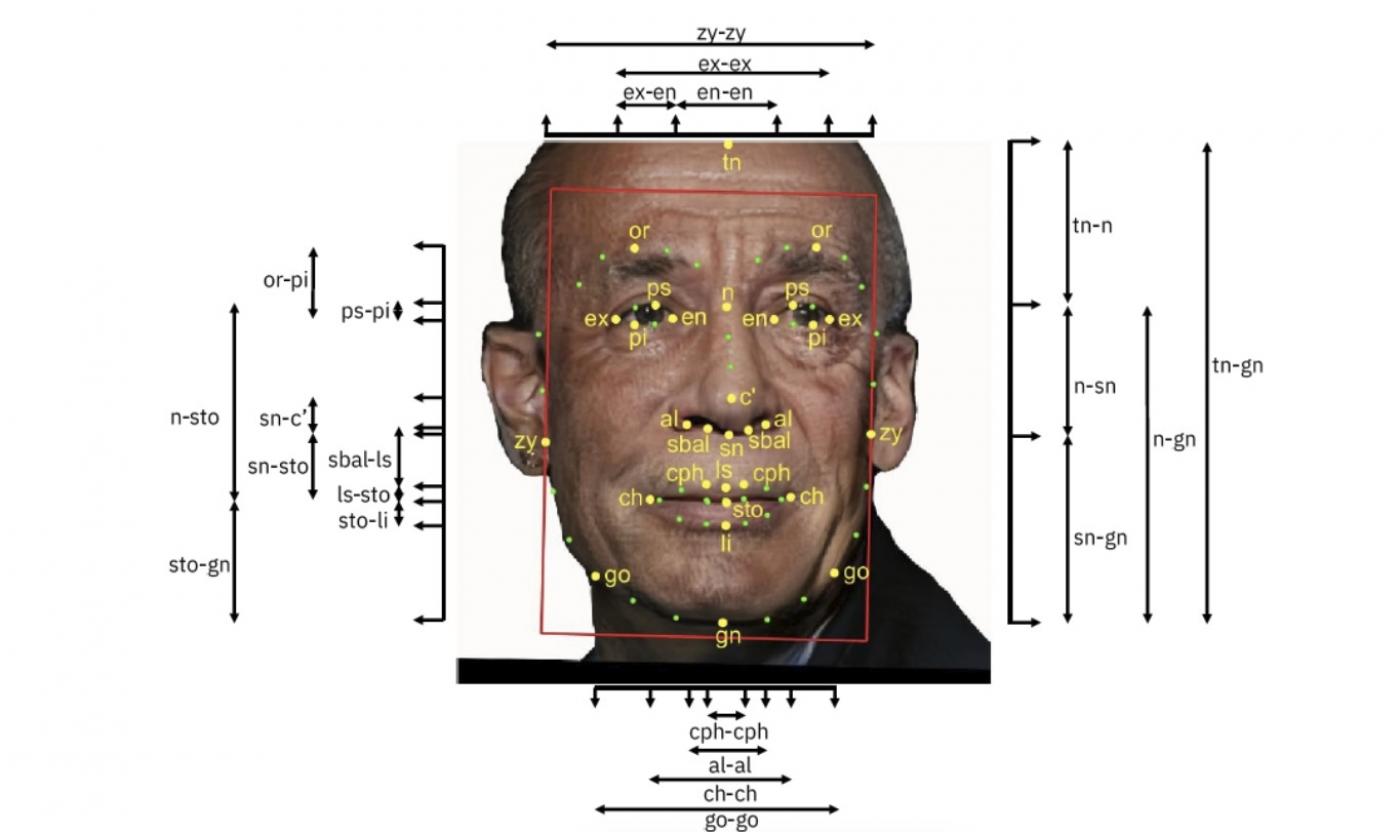

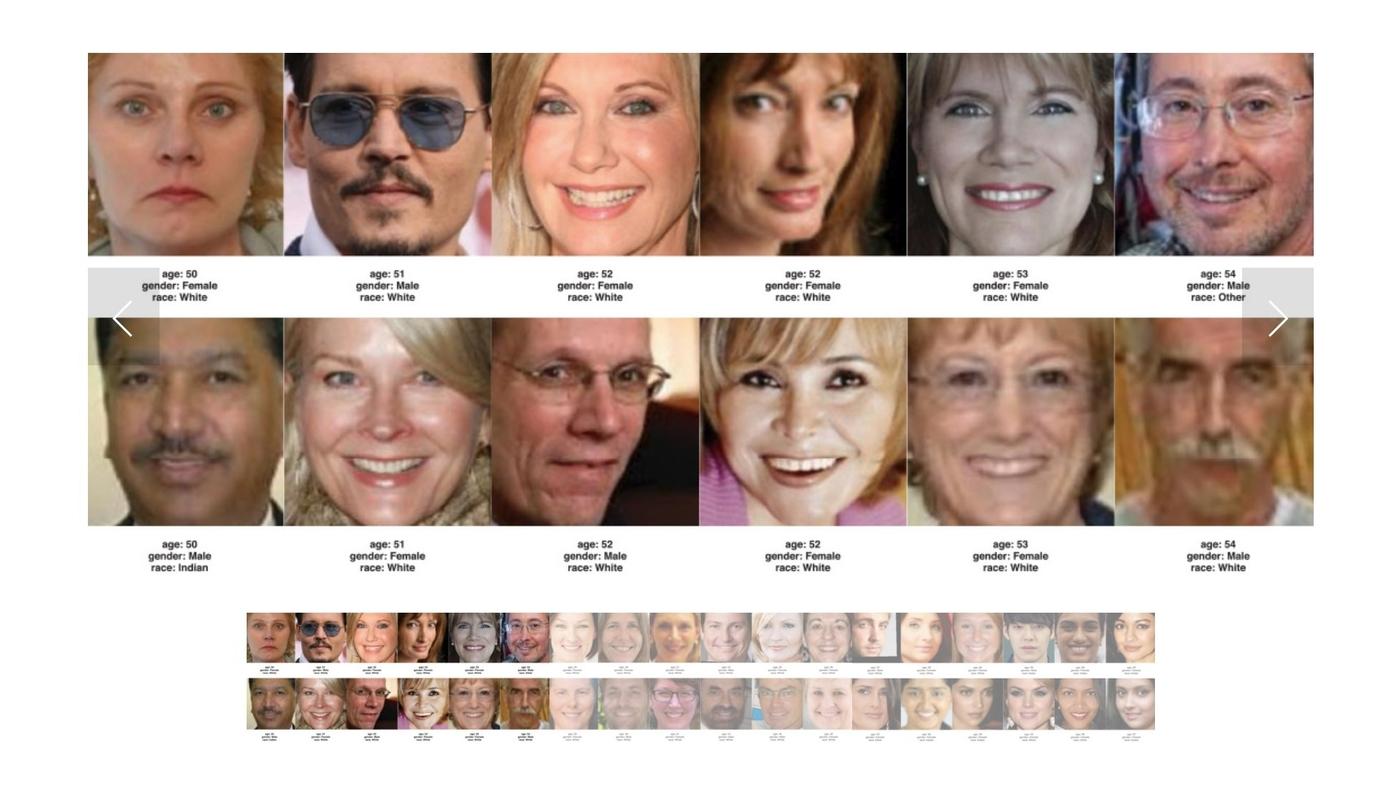

Les tentatives d’automatiser la perception visuelle, qui sont au fondement de la vidéosurveillance, remontent aux débuts de l’histoire de l’IA, dans les années 1950. « Mais ce n’est qu’autour des années 2010 que ces technologies connaissent une véritable explosion, explique Antonio Somaini, chercheur en esthétique, théorie et histoire des images à l’Université Sorbonne-Nouvelle. Et c’est essentiellement grâce à la création de très larges bases de données d'images (datasets), qui ont permis d'entraîner des machines dotées de réseaux de neurones artificiels (machine learning). » Le champ d’application de la vision automatisée, déjà très vaste, est en expansion permanente : dispositifs de surveillance (caméras, satellites), systèmes de guidage et d’observation (drones, missiles), voitures à pilotage automatique, reconnaissance biométrique et faciale, ou encore gestion du trafic...

Ces systèmes de machine vision sont dorénavant capables d’analyser des images, d’y détecter aussi bien des visages et des objets que des lieux, et d’en extraire des informations, des données. Par exemple, dans le cas d’un individu : son genre, son âge, son état émotionnel... Les machines font ce travail d’analyse sans que les images n’aient besoin de se manifester sur un écran ou pour un œil humain. Selon Antonio Somaini, qui étudie l’impact de l’IA sur la culture visuelle, cela représente « un vrai moment de rupture dans l’histoire des images », les notions même d’image et de vision devant être à nouveau interrogées.

Images invisibles

On assisterait ainsi à un véritable décentrement du regard : de l’humain vers la machine. « L’écrasante majorité des images sont réalisées par des machines pour d’autres machines, les humains étant rarement dans la boucle », écrit Trevor Paglen dans « Images invisibles (vos images vous regardent) », un article publié en 2016 dans The New Inquiry, qui a aussi influencé Antonio Somaini. Toutes ces images qui n’entrent pas dans le champ perceptif humain constitueraient ainsi un monde parallèle d’« images invisibles ». Ou encore une « terra incognita », selon Vincent Pécoil.

C’est cette opacité que Trevor Paglen pointe du doigt et essaie de percer à jour dans une série d'œuvres développées notamment avec l’appui de chercheurs et d’ingénieurs en IA à Stanford University. L'artiste-chercheur explore comment la machine vision opère et se déploie, notamment dans des photographies, des installations vidéos, ou encore une performance multimédia : Machine Readable Hito (à partir de portraits d’Hito Steyerl), Fanon (Even the Dead Are Not Safe), Behold These Glorious Times!, Sight Machine (en collaboration avec le Kronos Quartet).

Implications sociétales et politiques

Ce qui est pointé dans ces œuvres, en plus des questions théoriques, ce sont les implications sociétales, éthiques et politiques des systèmes de machine vision. Notamment l’érosion des libertés individuelles avec la recrudescence de la surveillance et la collection des données. Un projet comme Excavating AI, avec la chercheuse Kate Crawford du AI Now Institute de New York, soulève plus particulièrement des problèmes de biais : misogynes, racistes, classistes ou encore « simplement absurdes », inscrits au sein même des training sets, comme celui de la base de données ImageNet. Selon Trevor Paglen, ces déploiements technologiques s’imbriquent dans des structures de pouvoir, et constituent « de très puissants leviers de régulation sociale servant des intérêts spécifiques », notamment ceux des États et des géants de la tech, comme les GAFAM (Google, Apple, Facebook, Amazon, Microsoft, ndlr). Des intentions tout sauf neutres ou objectives.

© DR.

Eigenface, 2017

Impression par sublimation thermique.

© Trevor Paglen. Courtesy of the Artist, Altman Siegel, San Francisco and Pace Gallery.

© Trevor Paglen. Courtesy of the artist.

© DR.

Photo : Robert Divers Herrick. Courtesy of the artist.

Projection d’une vidéo couleur monocanale, stereo. S

10min

Original Score: Holly Herndon

Vue d’installation à Metro Pictures, New York, 2017.

© Trevor Paglen. Courtesy of the artist.

© DR.

© DR.

(Detail)

Adhésif mural.

© Trevor Paglen. Courtesy of the Artist, Altman Siegel, San Francisco and Pace Gallery.