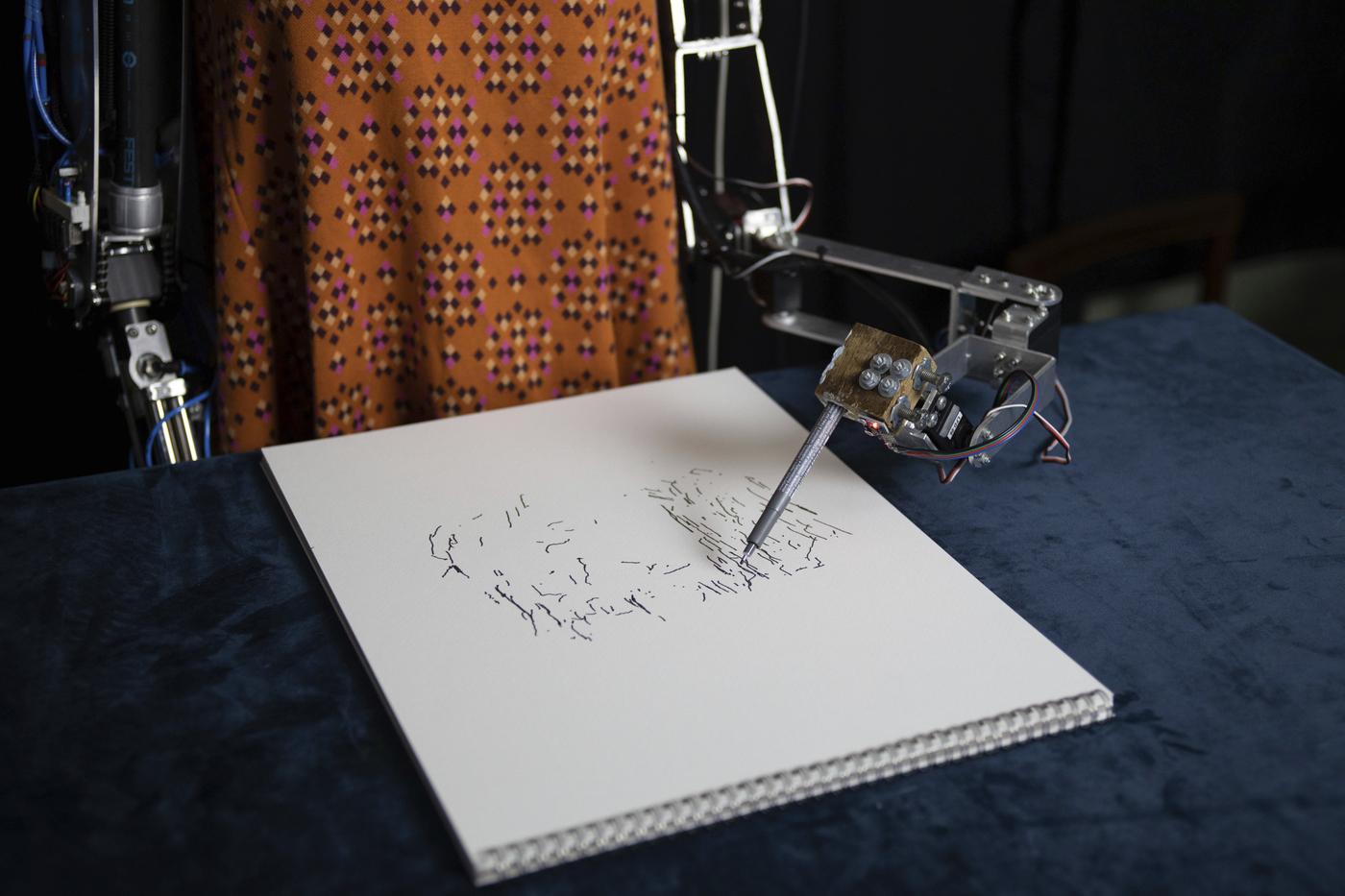

« Une bataille commence entre les humains et les artistes. » Point d’intrigue de film de science-fiction derrière cela, puisqu'il s’agit de l’incipit d’une étude menée par Ahmed Elgammal, chercheur à l’Université Rutgers. Selon ses résultats, publiés en février dernier, dans 75 % des cas les personnes interrogées n’étaient pas capables de faire la différence entre des œuvres produites par des artistes et d’autres générées par une intelligence artificielle (IA) – que l’on peut définir comme des travaux dont la conception a été calculée par une machine imitant l’intelligence humaine. La presse s’en est largement fait écho, à grand renfort de questions rhétoriques effrayantes : l’IA va-t-elle remplacer les artistes ? Et créer de façon autonome ? C’est la partition qu’a jouée l’université d’Oxford en dévoilant en 2019 Ai-Da, son artiste-robot humanoïde, vêtue d’une blouse de peintre, qui dessine ce qu’elle a devant elle. Pour Valentin Schmite, auteur de Propos sur l’art (L’art dit, 2020), « c’est un fantasme entretenu par les médias et les films de science-fiction. L’intelligence artificielle n’est qu’un outil dont les artistes peuvent s’emparer, un nouvel objet technique qui repousse les limites de ce qu’on peut faire ». Et de faire le parallèle avec la photographie à ses débuts contre laquelle nombre de créateurs s’étaient élevés.

Alors même que l’IA s’est infiltrée dans notre quotidien, des algorithmes de Spotify aux correcteurs automatiques des textos, de plus en plus d’artistes expérimentent ses potentialités, à l’instar de Mario Klingemann et Anna Ridler, qui font partie des figures du domaine. Mais l’idée n’est guère nouvelle. Dès la fin des années 1940, le mathématicien britannique Alan Turing, père de l’ordinateur, développe une machine qui rédige des lettres d’amour. La décennie suivante, Franck Molina crée des machines cinétiques tandis que Nicolas Schöffer fait danser des sculptures interactives à la Cité Radieuse dans une chorégraphie de Maurice Béjart. C’est la récente conjugaison de l’IA avec le big data qui lui a donné un nouveau souffle. Le deep learning permet en effet aux machines d’apprendre par elles-mêmes, grâce à un très grand nombre de données, pour en restituer des synthèses. Parmi les procédés utilisés par les artistes, les GAN (generative adversarial networks, « réseaux adverses génératifs » en français) utilisent des milliers de données (des peintures par exemple) dont ils déduisent des tendances pour créer de nouvelles pièces. Ils utilisent deux réseaux neuronaux : un générateur produit des images, textes ou sons, tandis qu’un discriminateur tente de déterminer si ces créations sont réelles ou ont été créées par le générateur. Le but : inventer des pièces au plus proche du réel.

Générateur de rêves

C’est la technique utilisée par Grégory Chatonsky dans son installation Terre seconde (2019), une autre planète faite à partir de la nôtre, en images, sculptures et sons. Un écran montre des organismes vivants alternatifs, une imprimante 3D sculpte des fossiles d’organismes fictifs tandis que dans un casque, une voix de synthèse lit des rêves générés à partir d’une base de données de 15 000 songes. Pour créer son installation Umwelt, exposée à la Serpentine Gallery en 2018-2019, Pierre Huyghe a quant à lui présenté des images et descriptions à des individus ; leur activité cérébrale a alors été capturée pour nourrir une intelligence artificielle qui a alors reconstruit des images de ces pensées humaines, diffusées sur des écrans. Le tout ne cessait de se métamorphoser en fonction de la lumière, la température ou des mouvements des mouches présentes dans la galerie. « Je ne veux pas exposer quelque chose à quelqu’un, mais plutôt le contraire : exposer quelqu’un à quelque chose », soutenait l’artiste en préambule de l’exposition.

Il est vraisemblable que l’intelligence artificielle s’invite de plus en plus largement dans l’art, grâce aux avancées de la recherche. En 2018, la France a initié un programme national, « L’intelligence artificielle au service de l’humain ». Les GAFA multiplient les programmes, comme « Art & machine intelligence » de Google, qui réunit artistes et ingénieurs. « En soutenant les formes émergentes de collaboration artistique, nous ouvrons nos recherches à de nouvelles façons de penser et de travailler avec les systèmes intelligents », se targue la firme de Mountain View. « Il est vraisemblable que les artistes s’emparent rapidement du GTP 3, un algorithme récemment développé par Google, soit la capacité de la machine à deviner la suite d’un texte », promet Valentin Schmite. Le duo Aurèce Vettier (Paul Mouginot et Anis Gandoura) l’a ainsi utilisé pour rédiger ses poèmes, Elegia Machina. De leur côté, les institutions se sont largement ouvertes aux travaux d’artistes travaillant avec l’IA : le Grand Palais avec « Artistes et robots » en 2018, le Centre Pompidou avec « Neurones, les intelligences simulées » en 2020, le New Museum de New York avec une monographie d’Ed Atkins en 2020, le Barbican center avec « A.I.: More Than Human » l’an dernier également.

Le marché quant à lui n’en est qu’à ses balbutiements. La vente de la toile Portrait d'Edmond de Belamy du collectif français Obvious chez Christie’s pour 432 500 dollars, 45 fois son estimation, avait certes fait grand bruit en octobre 2018. Mais deux autres toiles des mêmes millenials avaient fait un flop relatif chez Sotheby’s l’année suivante, cédées près de 95 % moins cher. Quelques mois auparavant, Memories of Passersby I de Mario Klingemann s’y était vendu 40 000 livres sterling, au ras de son estimation. « Ce qui était vraiment un marché de niche il y a encore trois ans est en train de se structurer, les prix montent », observe tout de même Valentin Schmite. Prochain rendez-vous, la foire CADAF, dédiée aux nouveaux médias, qui, après New York et Miami, tiendra sa prochaine édition « parisienne » en ligne en juin prochain.

© Ai-Da Robot project.

© Christie's Images Ltd, 2021.

Photo Ola Rindal/© Pierre Huyghe/Courtesy Pierre Huyghe et Serpentine Galleries, Londres.

© Starck/Kartell.

© Jean Christophe Lett pour Audi talents.

Photo Marion Carré.